Auf einer Informationswelle reitend stellt sich die Frage, was eigentlich gilt. Die IT kämpft von Anfang an mit der Schwierigkeit, Daten aus mehreren Quellen in einem Bericht zusammenzufahren, die gefundenen Daten zu verrechnen und aus den Ergebnissen den finalen Bericht zu erzeugen. Solange es nur einen Bericht gibt, fallen Unstimmigkeiten nicht auf. Berichte aus unabhängig voneinander laufenden IT-Systemen zu gleichen Themen zu erstellen, fördert unvorhersehbare Inkonsistenzen zutage. Hauptursachen sind die verschieden verstandenen und unabhängig voneinander erfassten Datenquellen und -wege.

Zuverlässige Daten erhöhen die Güte eines Berichts.

- Einen Speicherort

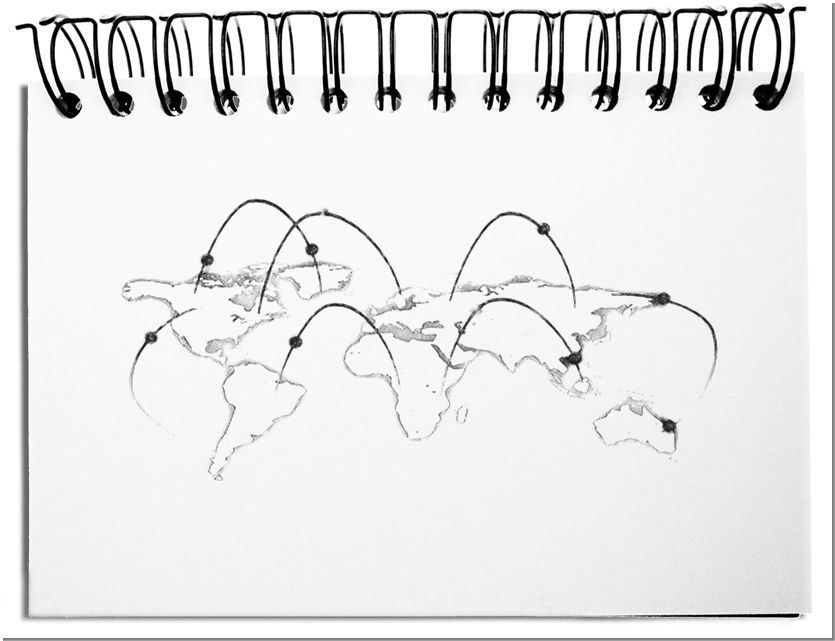

Redundant gespeicherte Daten führen aufgrund von Fehleingaben unweigerlich zu Inkonsistenzen, unabgestimmten Bedeutungen und unterschiedlichen Stichtagen. Die weltweite Vernetzung ermöglicht die Speicherung von relevanten Berichtsdaten zu einem festgelegten Zeitpunkt an einem Ort. Durch Plausibilitätschecks werden Fehleingaben minimiert. Am Ende sinken die Kosten durch einen Speicherort und zusätzlich durch die vermiedenen Fehler und Nacharbeiten. - Einheitliches Datenformat

Unterschiedliche Formate benötigen vor dem Berechnen, dass sie bereinigt werden (Data Cleansing). Textfelder müssen rechenbar gemacht, uneinheitliche Einheiten umgerechnet (Größenordnungen, wie Tausender oder Millionen; Maßeinheiten wie Meter und Yard; Währungen wie Dollar und Euro) und eine abgestimmte Anzahl Nachkommastellen geliefert werden. Allein die Stichtage beim Festlegen der Wechselkurse verwischen die Werte in Berichten. Vorgegebene Tabellen für das Umrechnen verringern Unstimmigkeiten. - Abgestimmte Bedeutung

An einer Zahl ist nicht erkennbar, was damit ausgedrückt werden soll. Verschiedene Blickwinkel führen zu verzerrten Zahlen und Aussagen. Betrachten wir als Beispiel die Anzahl Mitarbeitenden. Werden nur Festangestellte gezählt? Als Vollzeitäquivalente oder Kopfzahlen? Auch Befristete und Teilzeitkräfte? Zählen Praktikanten? Werden externe Freelancer, Berater und per Arbeitnehmerüberlassene eingerechnet? Der Zweck bestimmt die Zählweise. Möchte sich ein Bereich produktiver rechnen oder sollen die Kopfzahl groß gerechnet werden? Vor dem Erzeugen von internen Reports sollte die Bedeutung des Begriffs Mitarbeiter abgestimmt sein, da ansonsten falsche Schlüsse gezogen werden. - Synchronisierte Stichtage

Berichtszahlen folgen einer lokalen Logik, dienen der örtlichen Führung zur Steuerung und sind bestimmt durch die Bedingungen vor Ort. Dies bedeutet, dass die Erstellung durch die lokalen IT-Systeme und die dazugehörigen Abläufe zu einer Vor-Ort-Aktualität der Daten führen. Werden sie an einem zentral bestimmten Stichtag abgerufen, können sie aufgrund von unterschiedlichen Zeiträumen nicht zusammenpassen. Beispielsweise, wenn die lokalen Monatswerte am letzten Arbeitstag aufgrund unterschiedlicher Zeitzonen variieren – Wellington, Neuseeland versus San Francisco, USA. - Vorbereitete Querchecks

Verfügen wir nur über einen Bericht, bleiben die Fehler unbemerkt. Zusätzliche Infos können zu unterschiedlichen Ergebnissen führen. Ein Hinweis bieten die Summen der Gesamt- oder Bereichsergebnisse, die sich aufgrund der erwähnten Schwierigkeiten am Ende unterscheiden oder aufgrund unterschiedlicher Sichtweisen nicht zueinander passen. Fallen die erwarteten Zahlen zu hoch aus, dann wurden möglicherweise Zahlen doppelt gezählt. Fallen sie zu gering aus, könnten Zahlen falsch ausgelegt worden sein oder einfach fehlen. Querchecks braucht es immer! - Fortlaufende Anpassung

Da Fehler erst im Laufe der Zeit sichtbar werden, sollte die Güte der Daten kontinuierlich beobachtet werden. Sobald Unstimmigkeiten auftreten, sollten sie verstanden und ab dem Folgebericht richtiggestellt sein. Auf diese Weise kommen Sie irgendwann zu einem verlässlichen Berichtswesen.

Fazit: Wenn mehre Datenquellen vorliegen, führen Eingabefehler, fuzzy Erhebungszeitpunkte und unterschiedliches Auslegen von Daten zu nicht nachvollziehbaren Fehlern. Kommt es wiederholt zu Unstimmigkeiten, dann vertrauen die Leser dem Bericht und den Berichtenden nicht mehr. Die Zuverlässigkeit erhöht sich durch EINE Datenquelle, eine abgestimmte und verarbeitbare Datenstruktur, eine eindeutige Bedeutung, einen synchronisierten Stichtag, vorbereitete Querchecks und eine fortlaufende Anpassung, wenn Fehler erkannt werden. Der durchdachte Rechenweg liefert ein richtiges Ergebnis, das falsch ist, wenn die Datenqualität schlecht ist.